Dzięki sztucznej inteligencji najprawdopodobniej wkrótce będziemy mogli zapomnieć o używaniu klawiatury. Po co trudzić się wklepując poszczególne litery, skoro można po prostu zadać pytanie, pokazać problem na zdjęciu, a nawet pomyśleć od zadaniu do wykonania?

Nowe interakcje człowiek — AI - omówione zagadnienia:

- Jak działają interakcje w oparciu o Inteligentne Interfejsy Użytkownika (IUIs)?

- Biznesowe zastosowania interfejsów dotykowych

- Gesty w trzech wymiarach, rzeczywistość wirtualna i poszerzona

- Urządzenia i oprogramowanie sterowane głosem — jak wykorzystać je w swoim biznesie?

- Przyszłość interakcji, czyli interfejs mózg-maszyna

Dzięki nowym, inteligentnym interfejsom użytkownika (Intelligent User Interfaces, IUIs) również obsługa innych urządzeń oraz maszyn stanie się nie tylko prostsza, lecz również szybsza. Jakie perspektywy dla biznesu rysują się przed wspomaganymi przez AI metodami na interacje z urządzeniami?

Jak działają interakcje w oparciu o Inteligentne Interfejsy Użytkownika (IUIs)?

Inteligentne interfejsy użytkownika (Intelligent User Interfaces, IUIs) to interfejsy, które wykorzystują techniki sztucznej inteligencji do usprawnienia interakcji człowieka z urządzeniami. IUIs mogą na przykład rozpoznawać mowę lub gesty użytkownika, dostosowywać się do jego preferencji na podstawie analizy dotychczasowych interakcji, lub wspomagać go w wykonywaniu zadań. Celem jest bowiem stworzenie intuicyjnego i naturalnego sposobu komunikacji z urządzeniami elektronicznymi, czyli Natural User Interface (NUI). Choć obsługa takiego interfejsu też wymaga nauki, jest ona z założenia ułatwiona, co daje użytkownikowi poczucie, że wszystko dzieje się naturalnie, a interfejs sam w sobie jest niewidoczny.

Najczęściej wykorzystywane są dziś interfejsy dotykowe, a najbardziej rozwijane — interfejsy głosowe, natomiast do przyszłościowych rozwiązań należą: rozpoznawanie gestów w VR i AR, interfejsy inteligentnych rzeczy (Smart Devices) oraz interfejsy mózg-maszyna.

Przykłady zastosowań IUIs to inteligentni asystenci głosowi, tacy jak Siri czy Alexa, którzy rozumieją pytania zadane głosem i udzielają odpowiedzi lub wykonują polecenia. Innym przykładem są IUIs wykorzystujące czujniki do śledzenia ruchu ciała, gestów lub wzroku w celu sterowania urządzeniami. Wykorzystują one:

- przetwarzanie języka naturalnego (Natural Language Processing, NLP) do rozumienia i tworzenia wypowiedzi,

- rozpoznawanie obrazu (Computer vision) do interpretacji materiałów wizualnych,

- uczenie maszynowe (Machine Learning, ML) do rozpoznawania wzorców i przewidywania zachowań użytkownika.

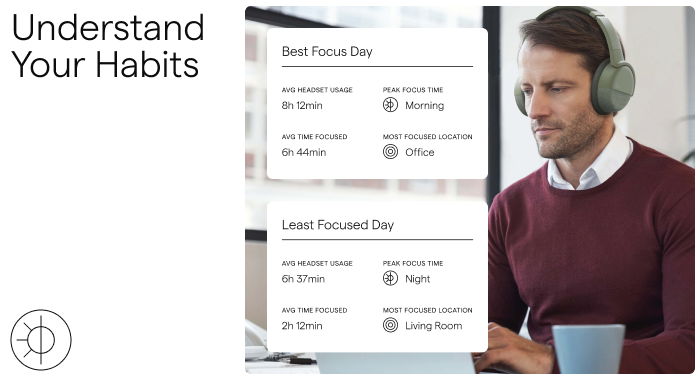

Uczenie maszynowe może być wykorzystywane między innymi do interpretacji fal mózgowych, wychwytywanych przez inteligentne słuchawki. Rozwiązanie to wykorzystała firma Neurable do stworzenia słuchawek dedykowanych do pracy, które wykrywają momenty skupienia i pozwalają na precyzyjne określenie optymalnej pory i warunków sprzyjających koncentracji. Co więcej, w czasie skupienia słuchawki Neurable automatycznie wyciszają przychodzące połączenia, oraz pozwalają na przeskoczenie do kolejnego słuchanego utworu za pomocą myśli.

Źródło: Neurable (https://neurable.com/headphones)

Biznesowe zastosowania interfejsów dotykowych

Interfejsy dotykowe cieszą się ogromną popularnością ze względu na swoją uniwersalność. Dlatego biznes przeniósł je szybko poza dziedzinę smartfonów i wyświetlaczy urządzeń gospodarstwa domowego. Są one coraz szerzej używane w automatach do sprzedaży biletów czy przekąsek, zamkach i lotniskowych bramkach.

Tapping, swiping, dragging, long-pressing — to tylko niektóre z gestów, które zdominowały nasze doświadczenia cyfrowe. Dzięki nim możemy zarówno pisać na wyświetlanej na ekranie klawiaturze, używać przycisków, jak i posługiwać się ruchami jednego lub wielu palców, a nawet całej dłoni.

Korzystające z AI urządzenia dotykowe stały się bardziej domyślne, uzupełniając fragmenty ruchu nierozpoznane poprawnie przez urządzenie. Łączą one dane z interfejsu dotykowego z gestami rozpoznawanymi przez kamerę, poprawiając płynność doświadczenia użytkownika oraz niepostrzeżenie zwiększając przyjemność i bezpieczeństwo korzystania z urządzeń.

Gesty w trzech wymiarach, rzeczywistość wirtualna i poszerzona

Dzięki rozpoznawaniu gestów coraz częściej używamy samego ruchu podczas bezdotykowych interakcji z drzwiami, umywalkami w łazienkach, czy ekranami samochodów. Powszechnie wykorzystuje je też motoryzacja. Na przykład, BMW niedawno wprowadziło funkcję sterowania gestami, która daje użytkownikom bezdotykową kontrolę nad głośnością samochodu, połączeniami i innymi funkcjami.

Warto także zwrócić uwagę na oprogramowanie umożliwiające bezdotykową obsługę urządzeń dostępnych w miejscach publicznych. Służą do tego:

- TouchFree — programowanie umożliwiające firmom modernizację istniejących kiosków i ekranów dotykowych opartych na systemie Windows do sterowania gestami bezdotykowymi,

- Banuba — rozwiązanie, które pozwala na obsługę gestami wykonywanymi w przestrzeni, na przykład wybieranie produktu przez wskazanie palcem lub dodawanie do koszyka gestem kciuka w górę, które będzie szczególnie przydatne w sklepach wykorzystujących technologie poszerzonej rzeczywistości, gdzie można na przykład przymierzać wirtualne ubrania,

Źródło: Banuba (https://www.banuba.com/solutions/touchless-user-interface)

Sztuczna inteligencja odgrywa bowiem kluczową rolę w sterowaniu gestami w rzeczywistości wirtualnej (VR) i poszerzonej (AR). AI jest tutaj wykorzystywana do rozpoznawania położenia ciała, interpretowania ruchów oraz gestów użytkowników, co pozwala na naturalną interakcję z wirtualnymi obiektami i środowiskami za pomocą rąk lub kontrolerów. Przykładem jest Oculus Quest 2, gogle VR wyposażone w kamery śledzące ruchy dłoni, co pozwala na intuicyjne sterowanie obiektami w wirtualnym świecie. VR i AR są wykorzystywane w biznesie do:

- praktycznych szkoleń i symulacji, gdzie sterowanie gestami umożliwia bardziej naturalną i intuicyjną interakcję,

- manipulowania modelami 3D podczas prac projektowych i inżynieryjnych, także w zespole, który nie jest zlokalizowany w jednej fizycznej przestrzeni,

- zakupów i prezentacji e-commerce – firmy wykorzystują AR do tworzenia interaktywnych doświadczeń zakupowych, gdzie klienci mogą używać gestów do przeglądania produktów i informacji.

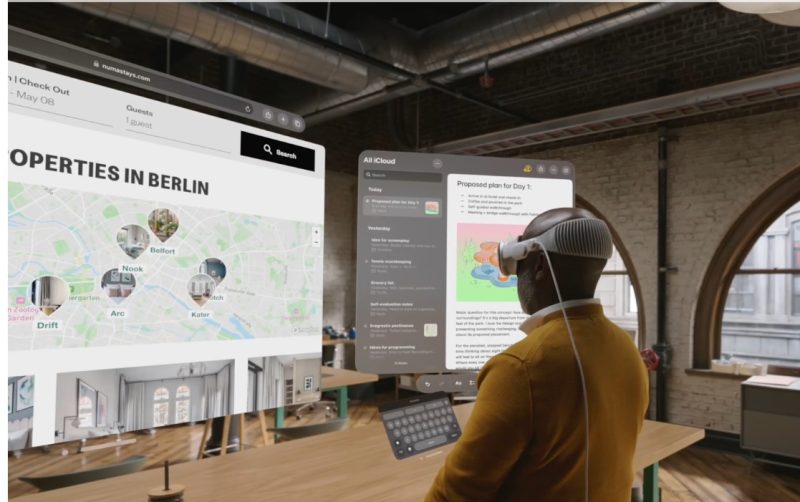

Jednym z najnowszych przykładów wykorzystania AI w sterowaniu gestami w VR i AR jest Apple Vision Pro. Jest to urządzenie typu „spatial computing”, które nie posiada sprzętowego mechanizmu sterowania. Zamiast tego, Vision Pro polega na śledzeniu ruchu oczu i gestów rąk, aby umożliwić użytkownikom manipulację obiektami w wirtualnej przestrzeni przed nimi.

Źródło: Apple (https://www.apple.com/newsroom/2023/06/introducing-apple-vision-pro/)

Apple Vision Pro wykorzystuje gesty, takie jak stukanie, podwójne stukanie, szczypanie i przeciąganie, a także gesty dwuręczne, takie jak powiększanie i obracanie. Gestów tych można używać do różnych działań, takich jak wybieranie i manipulowanie obiektami, przewijanie, przesuwanie okien i regulacja ich rozmiaru.

Urządzenia i oprogramowanie sterowanie głosem — jak wykorzystać je w swoim biznesie?

Rosnąca rola sztucznej inteligencji sprawia, że coraz więcej urządzeń i aplikacji korzysta także z interfejsów głosowych (Voice User Interface, VUI). Wykorzystują one technologie przekształcające mowę w tekst (speech-to-text, STT) i tekst w mowę (text-to-speech, TTS).

Sterowanie głosem już dziś znajduje bardzo szerokie zastosowanie w biznesie, ponieważ jest używane do:

- Obsługi klienta — klient może porozmawiać z inteligentnymi produktowymi i marketingowymi voicebotami, na przykład Inteliwise (Efecte),

- Tworzenia dokumentów — na przykład korzystając z Google Docs Voice Typing, która pozwala użytkownikom dyktować tekst bezpośrednio do dokumentu,

- Prowadzenia międzynarodowych spotkań — interfejs głosowy pozwala na tłumaczenie wypowiedzi w czasie rzeczywistym za pomocą automatycznego translatora, korzystając z Google Translate podczas rozmów prowadzonych w Google Meet, lub korzystając z dedykowanego narzędzia, na przykład w Verbum.ai.

Źródło: Verbum.ai (https://verbum.ai/).

Wiele osób korzysta także z głosowej obsługi oprogramowania samochodu, na przykład do ustalania celu nawigacji, oraz do sterowania urządzeniami typu Smart, służącymi do sterowania oświetleniem biura.

Przyszłość interakcji, czyli interfejs mózg-maszyna

Idealny sposób interakcji z urządzeniami byłby naturalny, czyli zupełnie niewidzialny dla użytkownika. I nie jest to czysta fantastyka. Istnieją już prototypy interfejsów mózg-maszyna, które działają z niewyobrażalną prędkością przypominającą elektroniczną telepatię.

Najbardziej zaawansowane prace nad interfejsem mózg-komputer, czyli brain-computer interface (BCI) prowadzi Neuralink. To firma, która opracowuje interfejs o nazwie „The Link”, który jest już w fazie testów klinicznych.

Źródło: Neuralink (https://neuralink.com/)

The Link to chip wielkości monety, który jest chirurgicznie wszczepiany pod czaszkę, gdzie łączy się z cienkimi drutami zwanymi nićmi neuronalnymi, które rozchodzą się do różnych części mózgu.

Nici neuronalne zawierają elektrody, które mogą rejestrować i stymulować aktywność mózgu, pozwalając na dekodowanie i kodowanie sygnałów neuronalnych i przesyłanie informacji do i z komputera lub urządzenia mobilnego.

The Link jest wszczepiany przez robota neurochirurgicznego, a potem umożliwia sterowanie aplikacją, która pozwala użytkownikowi manipulować klawiaturą i myszą za pomocą myśli.

Takie przyszłościowe rozwiązania budzą jednak tyle nadziei ile obaw. Z jednej strony będzie można po prostu pomyśleć: „Chcę zamieścić w mediach społecznościowych notatkę na temat eventu firmowego z portretowym zdjęciem CEO wykonanym podczas otwierania spotkania”. Z drugiej strony — w jaki sposób upewnić się, że połączenie nie podsłuchuje naszych prywatnych myśli?

Jeśli podobają Ci się treści, które tworzymy, sprawdź również: Facebook, Twitter, LinkedIn, Instagram, YouTube, Pinterest.

Autor: Marta Matylda Kania

Założycielka Superpowered by AI. Opracowuje dla biznesu procesy tworzenia treści przez generatywną sztuczną inteligencję. Interesuje się przyszłością AI w biznesie, pisze zaawansowane prompty i prowadzi szkolenia z ChataGPT dla firm.

AI w biznesie:

- O działaniu i biznesowych zastosowaniach voicebotów

- Wirtualny asystent, czyli jak rozmawiać z AI?

- Sztuczna inteligencja w biznesie. Wprowadzenie

- AI w biznesie: zagrożenia i szanse cz.1

- AI w biznesie: zagrożenia i szanse cz.2

- Automatyczne przetwarzanie dokumentów

- Automatyczny tłumacz. Inteligentna lokalizacja produktów cyfrowych

- Czatboty tekstowe wspomagane przez AI

- Dziś i jutro biznesowego NLP

- Czy sztuczna inteligencja zastąpi analityków biznesowych?

- Planowanie wpisów w mediach społecznościowych. W czym może pomóc AI?

- Automatyczne wpisy w mediach społecznościowych? Co może dzisiejsza AI

- Nowe produkty i usługi oparte o działanie sztucznej inteligencji

- Narzędzia AI dla managera

- Sześć pluginów do ChatGPT, które ułatwiają prowadzenie biznesu

- Czat GPT wchodzi do biznesu

- Burza mózgów z czatem GPT

- Syntetyczni prezenterzy. Najciekawsze narzędzia AI do tworzenia video

- Generatywna sztuczna inteligencja dla biznesu

- Muzyka i głosy AI w materiałach firmowych

- Czat GPT-4 - nowe możliwości dla biznesu

- Przyszłość AI według raportu McKinsey Global Institute

- Co to jest NLP, czyli przetwarzanie języka naturalnego w biznesie

- Zastosowania AI w biznesie. Przegląd

- Jak sztuczna inteligencja może pomóc w BPM?

- Rola AI w podejmowaniu decyzji biznesowych

- Czym jest Business Intelligence?

- AI i media społecznościowe – co o nas mówią?

- Sztuczna inteligencja w zarządzaniu contentem

- Dziś i jutro kreatywnej AI w biznesie

- Multimodalna AI. Nowe zastosowania sztucznej inteligencji w biznesie

- Hiperautomatyzacja i jej zastosowania w biznesie

- AI w EdTech. Przykłady 3 firm, które wykorzystały potencjał sztucznej inteligencji

- Nowe interakcje człowiek — sztuczna inteligencja. Jak AI zmienia sposób obsługi urządzeń?

- Przyszłość rynku pracy. Czy AI zastąpi ludzi?

- Sztuczna inteligencja i środowisko. 3 rozwiązania AI, które pomogą Ci budować zrównoważony biznes